Data Hub

Supprimez les silos organisationnels

Transformez vos sources de données dispersées en une puissance analytics unifiée. Construit sur Trino et Apache Iceberg, Data Hub vous permet de requêter PostgreSQL, MongoDB, S3 et 30+ connecteurs comme s'ils étaient une seule base de données.

Propulsé par des standards ouverts

Trino

Moteur SQL distribué et stateless. Requêtez n'importe quelle source de données avec du SQL standard, sans déplacer vos données.

Apache Iceberg

Format de table open source pour les data lakes. Transactions ACID, time travel, schema evolution et performance optimale.

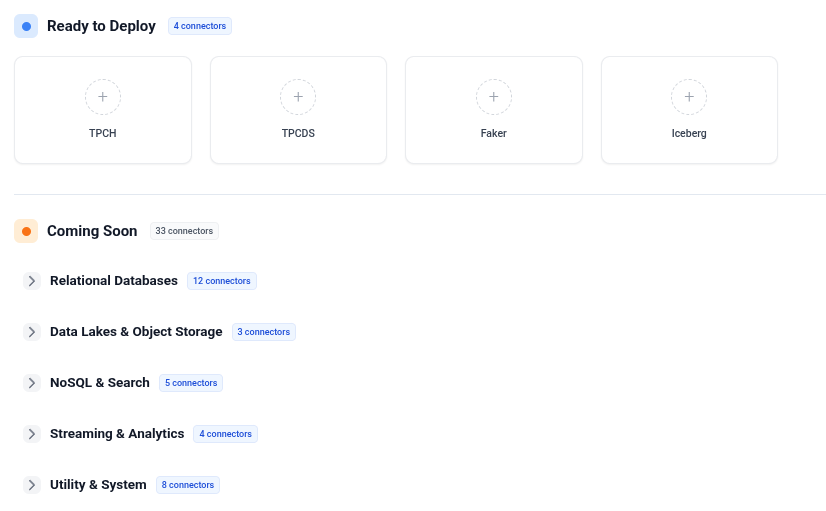

Connecteurs disponibles

PostgreSQL

Bases relationnelles

MySQL

Bases relationnelles

MongoDB

NoSQL

S3 / MinIO

Stockage objet

Kafka

Streaming

Elasticsearch

Recherche

Et bien plus à venir... 30+ connecteurs prévus.

Spécifications

Connecteurs

30+ prévus

Moteur SQL

Trino distribué

Stockage

Apache Iceberg

Cross-source

Jointures multi-sources

Dataset Branching

Prévu 2026

Auto Optimizer

Q4 2026

Cas d'usage

Analytics cross-source

Joindre PostgreSQL avec MongoDB dans une seule requête

Requêtez n'importe quelle sourceCalcul de KPIs complexes

Analytics avancées sur datasets distribués

10x plus rapide qu'un ETL traditionnelLakehouse unifié

Toutes vos sources de données dans une plateforme requêtable

50% de réduction des coûts infraEn action

La jointure impossible

Sarah doit joindre les données clients (PostgreSQL) avec les interactions produit (MongoDB)

- 1 Approche traditionnelle : Extract → Transform → Load (semaines de travail)

- 2 Approche Hyperfluid : Une requête SQL sur les deux sources

- 3 SELECT * FROM postgres.customers JOIN mongo.interactions...

- 4 Résultats en secondes, sans déplacer de données

Analytics complexes qui prenaient des semaines, maintenant en temps réel

La révolution KPI

L'équipe finance calcule le revenu mensuel à partir de 8 systèmes différents

- 1 Connecter les 8 systèmes via les connecteurs Data Hub

- 2 Écrire une requête SQL couvrant toutes les sources

- 3 Le moteur Trino distribue le calcul automatiquement

- 4 Calcul de revenu complexe avec attribution correcte

Reporting mensuel passé de 2 semaines à 30 minutes

La machine à remonter le temps

Grâce à Iceberg, voyagez dans le temps à travers vos données (Prévu 2026)

- 1 Créer une branche dataset pour l'analyse Q3

- 2 Expérimenter des transformations de données en sécurité

- 3 Comparer les résultats avec la branche principale

- 4 Merger les changements réussis ou abandonner les expériences

Expérimentation data sécurisée sans casser la production

Avantages clés

Prêt à unifier vos sources de données ?

Découvrez comment Data Hub peut éliminer vos silos de données.

Demander une démo